Je voudrais développer dans cet article une approche de stratégie IA potentiellement gagnante pour l’ Europe, ouvrant la voie vers une croissance économique dont nous avons bien besoin : des niveaux d’ endettement élevés, des États-providence non viables et une population en âge de travailler qui diminuera de 2 millions par an à partir de 2040 créent d’ énormes pressions budgétaires.

L’ IA pourrait inverser le malaise de l’Europe en matière de productivité et restaurer son dynamisme économique. Pour cela, je vais aborder successivement les questions suivantes : quelle est la bonne stratégie que l’ Europe doit adopter pour capturer le plus de valeur possible de l’ Intelligence Artificielle ? Quelles actions entreprendre pour se mettre sur la bonne voie ? Quels sont les faiblesses qui peuvent mettre l’ approche en péril ?

1. La stratégie de l’ aspiration

La stratégie de l’ aspiration fait référence à l’ effet dont bénéficient les pilotes de Formule 1 qui en suivent d’ autres; cette idée est également appelée en anglais The smart second-mover strategy par le Prof. Luis Garicano de la London School of Economy, qui a écrit plusieurs articles très intéressants sur le sujet. Je partage tout à fait son analyse et cite ses articles en référence.

L’ Europe se retrouve actuellement à la traîne dans la course aux modèles génératifs. Les Etats-Unis et la Chine dépensent actuellement des dizaines voire des centaines de milliards de dollars pour développer et exploiter les meilleurs modèles génératifs et se positionner en tête de la course.

Devons-nous chercher à courir dans ce peloton de tête, sachant qu’il ne sera pas facile de rattraper notre retard, tant au niveau des investissements que de nos faiblesses structurelles : manque de géants européens de la tech aux poches bien garnies, coût de l’ énergie bien supérieurs à ceux des Etats-Unis, contraintes administratives ralentissant la construction de nouveaux datacenters, cadre socio-économique décourageant la prise de risque ?

Par ailleurs, il n’ est pas du tout établi que l’ essentiel de la valeur financière se trouve dans la création de nouveaux modèles toujours plus performants. La disponibilité de modèles open-source puissants sur le marché montre bien que les barrières à l’ entrée sont faibles. La chute brutale des bourses américaines lors de la publication du modèle open-source Deepseek-R1 développé avec des moyens relativement modestes montre bien la fragilité de ce modèle économique. Le coût rapidement décroissant de l’ inférence à la demande par token est un autre indicateur du risque de banalisation des services d’IA générative, progressivement réduits à une simple commodité.

Une autre possibilité est d’ investir dans la couche matérielle, à savoir les technologies permettant de créer les circuits intégrés nécessaires à l’ exécution des modèles. On pense ici bien sûr à NVIDIA, principal fournisseur des processeurs, mais aussi à la fonderie Taiwanaise TSMC et au Néerlandais ASML qui est le leader sur le marché des machines de lithographie nécessaires à la gravure des puces haut de gamme. Je voudrais en profiter pour mentionner que le BeneLux n’ est pas mal placé dans la course, avec à la fois ASML à Eindhoven et l’ IMEC à Louvain qui est un des principaux centres de recherche mondiaux dans la miniaturisation et circuits électroniques et des nanotechnologies.

L’ Europe est en situation avantageuse dans la partie « amont » de la couche matérielle. Par contre, sa position est nettement moins favorable sur la partie « aval », à savoir la production de masse des processeurs avancés, qui se fait principalement en Asie, notamment par le leader mondial TSMC.

Mais il existe une troisième piste: mettre l’ accent sur l’ intégration de l’ IA dans les produits, applications et processus opérationnels des entreprises européennes. L’ idée est de devenir le meilleur et le premier des utilisateurs de l’ IA.

Et là, l’ Europe possède pas mal d’ atouts : un grand marché partiellement unifié de 450 millions d’ utilisateurs, un capital humain de premier plan, et de nombreux grands acteurs dans des secteurs industriels susceptibles de bénéficier fortement de l’ IA : industries aérospatiales et automobiles, production mécanique, industrie chimique et pharmaceutique, sans parler d’ un important tissu de PME techniques spécialisées dans les mêmes domaines.

Par ailleurs, ces secteurs sont souvent de grands producteurs de données spécialisées de qualité, qu’ elles proviennent des produits et services, des chaînes de production ou des systèmes de gestion des entreprises. Ces données, une fois consolidées par secteur, peuvent servir de base à des modèles IA spécialisés, qui peuvent être utilisés pour de la prédiction de qualité soutenus par des applications d’ IA générative lorsqu’ une capacité de raisonnement plus généraliste s’ avère nécessaire.

L’ idée est donc de profiter de ce que les autres fournissent pour banaliser leurs services, et en profiter pour créer une couche applicative profondément intégrée dans nos produits et activités. Ceci présente deux avantages : premièrement ces intégrations sont complexes et difficiles à banaliser. La propriété intellectuelle créée ne sera pas aisément recopiable et délocalisable. Et deuxièmement, cela offre d’ importantes possibilités de gains de productivité et de réduction des coûts à travers l’ automatisation d’ un certain nombre de tâches actuellement réalisées par des humains.

2. Comment nous mettre sur la bonne voie

La liste des actions possibles est longue, mais on peut définir trois grands axes:

Premièrement, mettre en place des standards ouverts pour l’ IA générative.

Il s’ agit ici de rendre les modèles IA généralistes (ChatGPT et autres) interchangeables et de les marchandiser en les régulant. Une direction logique serait de standardiser l’ accès aux modèles par API; on peut également plafonner le prix chargé par token ou encore interdire les clauses contractuelles d’ exclusivité et limiter les délais de préavis de résiliation de service. Il faudrait aussi s’ assurer que données échangées avec ces fournisseurs de service sont portables et récupérables par les clients, par exemple l’ historique des dialogues ou les données d’ entraînement utilisées pour un affinage de modèle.

Deuxièmement, aménager l’ EU AI Act pour le rendre plus pro-innovation.

Je pense que l’ AI Act dans son principe est une bonne chose car il offre un cadre légal prévisible aux développeurs d’ applications. Cependant, son formalisme reste très abstrait et généraliste et donc difficilement utilisable en l’ état, alors que les dates d’ entrée en vigueur approchent rapidement (août 2026 pour la plupart des applications). Ces dates devraient être retardées pour donner le temps aux autorités de définir des règles concrètes applicables à chaque secteur d’ activité. Le flou actuel est d’ autant plus gênant que l’ Act repose largement sur des mécanismes d’ auto-évaluation par les implémenteurs ce qui les met dans une situation pour le moins inconfortable…

Par ailleurs, la réglementation exige la création d’ un important paquet de documentation dès le déploiement initial de l’ application IA, ce qui pose des difficultés particulières pour les petites entreprises. Une approche de mise en conformité plus itérative et progressive serait souhaitable. Ces soucis avec l’ EU AI Act sont à la base de nombreuses réactions du monde patronal qui demande une mise en pause temporaire, comme cette lettre de 46 CEOs de multinationales européennes qui demande un report des échéances de deux ans (référence ici).

Troisièmement, constituer un écosystème européen des données

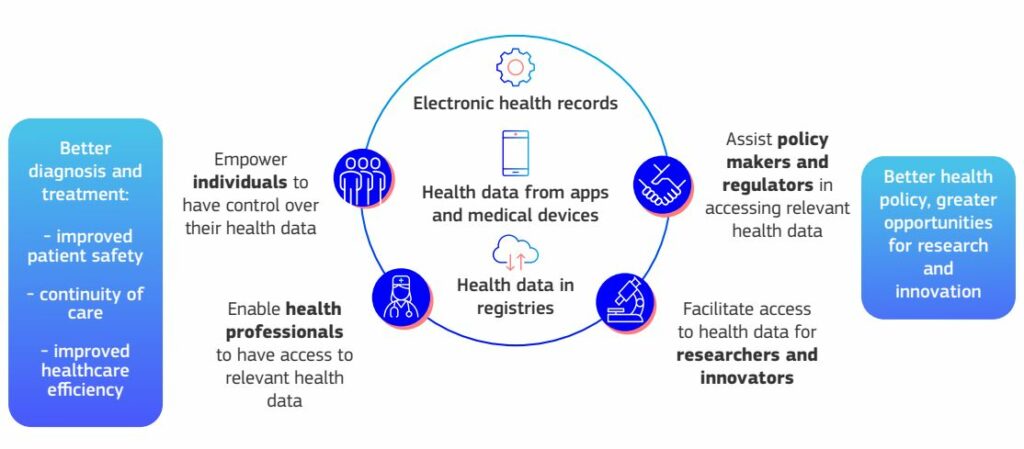

C’ est un vaste sujet qui mériterait au moins un article entier à lui tout seul. L’ Union Européenne a défini une stratégie pour constituer des ensembles sectoriels de données. Un premier pas a été franchi en mars 2025 avec l’ European Health Data Space Regulation (EHDS) qui définit les mécanismes et infrastructures pour consolider les données de santé de manière harmonisée au niveau européen, afin de pouvoir entraîner les modèles IA du futur. Une réglementation analogue est actuellement en cours de discussion pour le secteur financier. Lorsqu’ elle sera finalisée, la stratégie européenne des données devrait couvrir quatorze domaines ayant chacun leur espace de données consolidé.

Outre ces trois axes spécifiques à l’ IA, toute mesure générale favorisant l’ innovation est évidemment la bienvenue. Que cela concerne l’ accès aux capital-risque ou la mise en place d’ un type de société pan-européen -le fameux « 28ème régime »-, des initiatives inspirées par le rapport Draghi sur la compétitivité sont en cours de réalisation et doivent être encouragées.

Sur le plus long terme, rien n’ est possible sans une éducation de qualité. Je suis convaincu que l’ éducation est un des domaines ou l’ IA peut apporter le plus de progrès. La relative fragmentation de l’ Europe en 27 systèmes éducatifs distincts peut s’ avérer être ici une force cachée : cela permet de lancer différents types d’ initiatives par pays et de déployer ensuite les meilleures pratiques dans les autres pays.

3. Nos risques et nos faiblesses

Un de nos problème est que de nombreux emplois en Europe se retrouvent dans des secteurs difficiles à automatiser, comme les soins liés au vieillissemnt de la population, le tourisme ou encore les administrations. En l’ absence d’ une révolution en robotique, les soins de santé aux personnes âgées et le tourisme requièrent une interaction humaine et se prêtent mal à l’ automatisation. Dans le cas de l’ administration publique également, de nombreux emplois ne sont pas automatisables facilement : policiers, pompiers, soldats, enseignants sont non seulement difficilement remplaçables mais disposent en général d’ un status privilégié et d’ une puissante représentation syndicale.

Ce qui mène au second point, la résistance au changement. Contrairement à d’ autres régions du monde, l’ Europe possède des règles de protection de l’ emploi extrêmement fortes qui peuvent décourager la prise de risque. Ces règles réduisent considérablement la mobilité des travailleurs et rendent la réallocation des ressources entre entreprises très coûteuses. En outre, les travailleurs de certains secteurs disposent de moyens de pression supplémentaires par leur capacité à paralyser un pays avec un nombre relativement limité de grévistes (transports, agriculteurs…).

Ces résistances au changement sont également de nature réglementaire, avec un « principe de précaution » qui peut s’ avérer contre-productif. Le cas de la législation européenne sur les OGM est emblématique : la culture de nourriture OGM pour la consommation humaine est extrêmement limitée en Europe (en pratique seul maïs OGM est cultivé) alors que, de l’ aveu même des autorités sanitaires de l’ UE, ces derniers ne sont pas plus dangereux que les aliments obtenus par des voies traditionnelles. Ceci est d’ autant plus incompréhensible que l’ Union Européenne importe des quantités importantes de nourriture OGM depuis l’ extérieur de ses frontières (par exemple: germes de soja, huile de colza…) pour la consommation humaine !

Un autre frein à l’ automatisation qui relève indirectement du principe de précaution est plus insidieux : l’ exigence réglementaire d’ avoir un humain dans la boucle dans de nombreux processus critiques. Ceci peut sembler une bonne idée au premier abord, mais aura pour conséquence que la rapidité d’ exécution du processus sera conditionée par la rapidité de l’ humain le plus lent dans le processus, en espérant qu’ il ne soit pas malade ou en vacances…

Cette idée de surveillance humaine est noble dans le principe mais peut s’ avérer contre-productive dans certains cas. Le trading d’ actions à haute fréquence en est un exemple, où l’ exigence de supervision humaine sur chaque ordre boursier rend cette stratégie financière inutilisable en pratique. Un exemple encore plus frappant est le tri des patients aux urgences en cas de suspicion d’ AVC où chaque minute compte. Une IA peut analyser le résultat d’ un scanner lors de l’ arrivée à l’ hôpital et donner un pré-diagnostic en quelques secondes ce qui permet l’ envoi immédiat dans la bonne unité de soins. Attendre qu’ un radiologue donne son diagostic ajoute 30 à 60 minutes (voire plus en période de nuit ou de weekend) et ce délai peut s’ avérer fatal…

Le danger est que l’ ensemble de ces contraintes réduisent très fortement le champ d’ action de l’ automatisation par l’ IA en Europe par rapport à d’ autres régions du monde qui n’ auraient pas les moindres scrupules…Pour ma part je pense que cela vaut la peine de prendre certains risques, quitte à réglementer ex post en cas de problèmes.

4. Conclusion

Sur le fond, je pense que les gains de productivité grâce à l’ IA auront lieu, mais qu’ ils seront plus lents que prévu. Tout comme à l’ époque du boom internet en 1998-2001, un nombre incroyable d’ idées ont jailli en très peu de temps, mais beaucoup d’ entre elles se sont avérées irréalistes vu l’ état des techniques à l’ époque. Leur heure n’ était pas encore venue, mais toutes ces idées ont servi de terreau pour les progrès des vingt années qui ont suivi et la plupart d’ entre elles ont fini par prendre forme.

Je pense que la situation est analogue dans le case de l’ IA. Lorsque j’ entends les PDG des géants de la tech parler d’ une transformation en profondeur de la société vers 2030, je pense qu’ ils ont raison sur le fond mais pas sur le calendrier. Je pense que tout cela sera plus lent et plus progressif. Pour ma part je ne serais pas surpris que la transition dure entre 15 et 20 ans vu l’ énormité de la tâche et les résistances à attendre.

Difficile aussi de quantifier les gains de productivité. Si les économistes les plus prudents estiment l’ impact à environ 2% de croissance du PIB sur dix ans, d’ autres vont jusqu’ à imaginer une croissance de 30% par an ! Les deux dernières références de la liste ci-dessous présentent de telles analyses. Tout dépend de la proportion des tâches effectivement automatisées…

Sources et références

- The smart second mover, article par Luis Garicano pour Silicon Continent le 9 juillet 2025 : https://www.siliconcontinent.com/p/the-smart-second-mover

- Can AI solve Europe’s problems ?, article par Luis Garicano pour Silicon Continent le 26 juin 2025 : https://substack.com/home/post/p-166874576

- The Washington Effect? Europe Weighs Pausing the AI Act par Anda Bologa pour CEPA, le 8 juillet 2025 : https://cepa.org/article/the-washington-effect-europe-weighs-pausing-the-ai-act/

- EU guidelines on AI use met with massive criticism par Jürgen Hill pour CIO Magazine le 16 juillet 2025 : https://www.cio.com/article/4022707/massive-criticism-of-eu-guidelines-on-the-use-of-ai.html

- AI and explosive growth redux par Andrei Pologea et Anson Ho pour EpochAI le 21 juin 2025 : https://epochai.substack.com/p/ai-and-explosive-growth-redux

- The Simple Macroeoconomics of AI, article académique de Daron Acemoglu du MIT le 5 avril 2024 : https://economics.mit.edu/sites/default/files/2024-04/The%20Simple%20Macroeconomics%20of%20AI.pdf